Introduction aux Statistiques

Citation :

Introduction aux statistiques - © 1996, Ramousse R., Le Berre M. & Le Guelte L.

|

|

Les analyses de variance ou analyses factorielles sont des techniques permettant de savoir si une ou plusieurs variables dépendantes (appelées aussi variables endogènes ou variables à expliquer) (valeurs numériques et continues [c-à-d des effectifs, des rapports comme des longueurs ou des poids, etc..] = disposées dans différentes lignes d’un tableau) sont en relation avec une ou plusieurs variables dites indépendantes (ou variables exogènes ou variables explicatives) (disposées dans différentes colonnes d’un tableau).

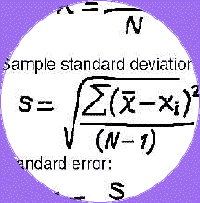

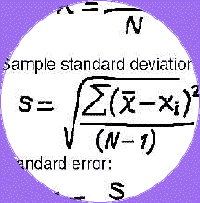

C’est la somme des carrés des écarts par rapport à la moyenne / nombre de degrés de liberté = SCE/ddl (ceci lorsque le nombre d’individus composant l’échantillon est réduit ; sinon, utiliser N’=N). La variance est le carré de l’écart-type. La variance d’un échantillon peut se calculer manuellement, ou à l’aide d’Excel, ou avec Statview II.

![]()

Quatre situations principales peuvent être rencontrées, cependant, nous ne développerons que la première :

•Avec une seule variable dépendante (à expliquer), et une ou plusieurs variables explicatives discrètes (dites aussi catégorielles, qualitatives, nominales, de classification = ne pouvant donc prendre qu'un nombre limité de valeurs comme le sexe, la catégorie socio-professionnelle, etc...) on utilise l'analyse de variance. On appelle facteurs les variables explicatives. L'analyse consiste à tester si les différences de variation dans chaque groupe (ou échantillon) défini par les modalités des variables explicatives s'écartent de manière significative de la valeur 0.

•Avec toujours une seule variable à expliquer, mais une ou plusieurs variables explicatives, toutes continues, on fait appel au modèle de régression linéaire simple ou multiple : on appelle régresseurs les variables explicatives. La régression consiste à évaluer les paramètres d'une fonction linéaire, à estimer à l'aide de cette fonction les valeurs de la variable à expliquer et à tester si les différences (= les résidus) entre valeurs mesurées et valeurs estimées s'écartent de manière significative de 0.

•Lorsque certaines des variables explicatives sont discrètes (discontinues), et d'autres continues, on réalise une analyse de la covariance. Le modèle se compose donc à la fois de facteurs et de régresseurs. On cherche si les relations entre la variable à expliquer et les variables explicatives continues restent les mêmes pour toutes les modalités des variables explicatives discrètes.

•Lorsqu'il y a plusieurs variables à expliquer à prendre en compte simultanément, au lieu de faire plusieurs analyses de variance (une par variable à expliquer), on réalise une analyse de variance multiple. On teste si les différences de variation dans chaque groupe défini par les modalités des variables explicatives s'écartent de manière significative de la valeur 0, et cela de manière simultanée dans l'ensemble des variables explicatives (d'où la différence avec l'analyse de variance simple).

Seuls des échantillons suivant une loi normale peuvent faire l’objet d’une analyse de variance paramétrique. Pour vérifier que la distribution d’un échantillon suit une loi normale, il est possible d’utiliser, dans Statview II, le test descriptif d’aplatissement et d’asymétrie (de kurtosis and skewness, en anglais).

On considère que l’échantillon suit une loi normale à 95 % lorsque la valeur de son aplatissement est compris enttre -2 et +2.

On calcule les différentes variances pour chacun des échantillons à comparer, et on fait le rapport de la plus grande sur la plus petite, ce rapport est F.

Cette valeur est comparée, dans une table de Hartley (ou du Fmax), à une valeur théorique et doit lui être inférieure pour un seuil de risque choisi (par exemple, 95 %) pour conserver l'hypothèse d'homogénéité des variances.

Les d.d.l. sont, pour la colonne de la table du Fmax, le nombre de traitements (=k) (colonnes de données), et pour la ligne de la table, le nombre de données du plus grand échantillon - 1 (=n-1).

L'hypothèse nulle H0 est l'égalité des moyennes des populations dont sont extraits les échantillons : m1=m2=m3=...=mk

Notation : Le nombre d'échantillons est noté k, le nombre de mesures par échantillon est désigné par n et le nombre total de mesures, kn.

L'analyse de variance à un facteur (one-way analysis of variance) va consister à chercher le rapport entre la variance entre les groupes (V. inter-groupe) et la variance à l'intérieur des groupes (V. intra-groupe).

La valeur de ce rapport appelé F [attention : ce F n’a rien a voir avec le F du test de vérification de l’homogénéité des variances] est comparée à celle d'une table de F de Snedecor, table à double entrée avec pour numérateur le [nombre d'échantillons (k) moins un] soit (k-1) et pour dénominateur le [nombre total de mesures - k] soit (kn-k).

a) la variance totale par rapport à la moyenne globale des n mesures ; b) la variance intra-groupes (celle qui n'est pas liée aux conditions expérimentales). 2. Par différence [a-b] on obtient la variance inter-groupes (qui est liée aux différences de conditions expérimentales).

3. On calcule le rapport : F = variance inter-groupes/variance intra-groupes ou résidu. [attention : ce F n’a rien à voir avec le F du test de vérification de l’homogénéité des variances] Notation : Le terme "traitement" peut être remplacé par "variable expérimentale" ou "condition expérimentale" ou quoi que ce soit qui différencie les groupes (colonnes). De même, le terme "individu" peut concerner différentes entités : des points de prise d'échantillons le long d'une rivière, des êtres vivants, etc (lignes) ...

Calculs intermédiaires à réaliser pour un traitement manuel (ou avec un tableur) :

(1) Décomposition de l'analyse de variance :

1. Manuellement, on calcule :

![]()

![]()

![]()

![]()

![]()

![]()

![]()

![]()

![]()

![]()

![]()

![]()

![]()

![]()

![]()

![]()

![]()

![]()

![]()

![]()

![]()

![]()

![]() (2)

(2)![]() (3)

(3)![]()

![]() -

- ![]()

![]() -

- ![]()

![]() -

-![]()

On veut savoir si la quantité de nitrates varie d'une station à l'autre le long d'une rivière. Pour cela, on prélève en 10 points (n=10) chaque fois une certaine quantité d'eau dans 3 stations différentes (k=3).

Nitrates

Somme des carrés des écarts (SCE) entre traitements (inter-groupe) =

![]() ou =(S(moyTj-moyX)2)*n

ou =(S(moyTj-moyX)2)*n

Sommes des carrés des écarts (SCE) expérimentales (erreur exp) ou résidu (intra-groupe) =

![]() -

-![]() ou = S(S(X-moyT)2)

ou = S(S(X-moyT)2)

![]() -

- ![]() ou S(X-moyX)2

ou S(X-moyX)2

D’où :

Variance inter-groupes = SCE inter-groupes/ddl = 1732,47/2 = 866,23

Variance intra-groupes = SCE intra-groupes/ddl = 168285/27 = 6232,78

Calcul de F = Variance inter-groupes / Variance intra-groupes = 0,14

Les échantillons à comparer étant indépendants, on disposera l’ensemble des mesures dans une seule colonne (Y1) et les numéros des échantillons des individus dans une seconde colonne (X1).

Conclusion du test statistique : La valeur de P étant largement supérieure au seuil de signification 0,05, on conserve donc l’hypothèse nulle (pas de différence significative entre les échantillons).

Conclusion de l’expérience : pour cette série de mesures, on peut donc conclure que les taux de nitrates des trois stations ne diffèrent pas significativement ou que ces 3 stations ne diffèrent pas significativement par leur taux de nitrates avec une seuil de signification (risque d’erreur) de 5%.

On dispose de k=3 échantillons comprenant n=5 individus dont les valeurs sont données dans le tableau ci-après : il s’agit des différences de temps de réaction pour trois souches de souris soumises à une même expérience.

Analyse de la variance (Statview II)

Estimation de la variance entre composants = 6,1333

Dans cet exemple, la valeur de F(2,12) est très supérieure au seuil de signification de 1% : 6,93. La probabilité exacte calculée est de 0,0001.

L’hypothèse nulle est donc rejetée. On considère que les 3 échantillons diffèrent significativement (la probabilité de se tromper est de 0,0001).

N.B. : Déviation standard = écart-type = racine carrée de la variance. Erreur standard = erreur type = écart-type/Racine carrée de n

* significatif à 95%

La significativité des tests PLSD de Fischer et F de Scheffé permet de considérer qu’il y a une différence significative entre les souches 1, 2 et 3 de souris testées.

Ces trois souches réagissent donc de façon significativement différentes au traitement : le groupe 3 présente des temps de réaction significativement plus courts que les deux autres groupes. Le groupe 1 est le plus lent.

Cette situation correspond aux échantillons appariés des tests pour deux échantillons.

![]()

![]()

![]()

![]()

![]()

![]()

![]()

![]()

![]()

![]()

![]()

![]()

Calculs à réaliser dans le cas d’un traitement manuel (ou avec un tableur) :

(1)?![]() ? (2)?

? (2)?![]() ?(3)?

?(3)?![]() ?(4)?

?(4)?![]()

Décomposition de l'analyse de variance :

![]() -

- ![]()

![]() -

- ![]()

![]() -

- ![]()

![]() -

- ![]() -

- ![]() +

+ ![]()

![]() -

- ![]()

Pour simplifier, on reprend les valeurs de l’exemple précédent (§3.2.), en considérant qu'elles correspondent cette fois à la quantité de nitrates mesurée aux mêmes points de prélèvements, au cours de 3 saisons, dans une station le long d'une rivière.

X1

X2

X3

total

50,00

162,00

120,00

332,00

52,00

350,00

120,00

522,00

123,00

125,00

122,00

370,00

100,00

320,00

221,00

641,00

200,00

112,00

253,00

565,00

250,00

200,00

141,00

591,00

220,00

40,00

182,00

442,00

10

220,00

162,00

175,00

557,00

k

300,00

160,00

160,00

620,00

3,00

220,00

250,00

214,00

684,00

total=G

total

1735,00

1881,00

1708,00

5324,00

5324,00

(1)=

![]()

944832,53

(2)=

![]()

1114850

(3)=

![]()

1735^2/n+1881^2/n+1708^2/n

946565,00

(4)=

![]()

332^2/k+522^2/k+...684^2/k

985621,33

se décompose en : = k*(S(Pi/k-moyX)2) =S(Xij-Pi/k)2 somme carrés inter-traitements ou =n*(_(moyTj-moyX)2) =somme carrés totale - somme carrés interindividus - somme carrés intertraitements

Somme carrés totale ou =S(Xij-moyX)2

(2)-(1)

170017,47

Somme carrés inter-individus ou

(4)-(1)

40788,80

et somme carrés intra-individus ou

(2)-(4)

129228,67

Cette dernière se décompose en 2 parties :

(3)-(1)

1732,47

et somme résiduelle des carrés ou

(2)-(3)-(4)+(1)

127496,20

Présentation des données : les échantillons étant appariés (mesures répétées), les valeurs mesurées sont placées dans des colonnes différentes affectées des variables X1, X2, X3, Xn.

Conclusion du test statistique : La valeur de P étant largement supérieure au seuil de signification 0,05, on conserve donc l’hypothèse nulle (pas de différence significative entre les mesures répétées).

Conclusion de l’expérience : pour cette série de mesures, on peut donc conclure que les taux de nitrates des trois séries de mesures ne diffèrent pas significativement ou que cette station ne présente pas de variation significative du taux de nitrates, au cours des trois saisons de mesure, avec un seuil de signification (risque d’erreur) de 5 %.

On étudie l’influence d’une substance sur le temps de réaction de n=5 sujets préalablement entraînés à répondre à un stimulus. L’ordre selon lequel chaque substance est administrée à chaque sujet est déterminé de manière aléatoire. Une durée suffisante est observée entre l’administration de deux substances différentes. Les résultats obtenus sont des temps de réaction sous l’influence de chacune des k=4 substances testées.

Fiabilité pour : toutes les séries = 0,6823 ; une seule série = 0,3494

* significatif à 95%

Ce tableau permet de compléter l’ANOVA en comparant les moyennes des groupes (colonnes) deux à deux. Les tests proposés par Staview sont : le PLSD de Fischer, le F de Scheffé et le t de Dunnett.

Le PLSD de Fischer (Procédure de "least significant difference method" de Fisher) est utilisé pour tester l’hypothèse nulle que toutes les moyennes de la population sont égales. C’est une méthode pour contrôler les erreurs de type 1 lorsque l’on compare plusieurs paires de moyennes. Lorsque les résultats de l’ANOVA sont significatifs, on peut comparer les moyennes des groupes 2 à 2 en utilisant un test de t.

Le F de Scheffé permet de déterminer si, après une ANOVA significative, les moyennes de 2 des groupes de la variable indépendante diffèrent. Le test de Scheffé ne demande pas que tous les échantillons utilisés dans l’ANOVA aient la même taille. Le test de Tukey, lui, nécessiterait des échantillons de même taille. Ce test très conservatif ne devrait être utilisé que quand tous les échantillons de l’ANOVA ont des tailles différentes.

L'intervalle de Scheffé associe l'erreur d'estimation pour chaque moyenne en utilisant la méthode de F-distribution. Cela permet de faire des comparaisons linéaires parmi les moyennes de l'échantillon tout en contrôlant le taux d'erreur ("experiment wide error rate") à un niveau défini.

Le test de Dunnett est un test spécialisé pour la comparaison multiple. Le test de Dunnett est employé quand les comparaisons ne sont faites qu’avec le groupe témoin contre tous les autres groupes.

Autres tests de comparaison de moyennes non disponibles dans Statview II :

Le HSD (honestly significant difference) intervals de Tukey : La technique du HSD de Tukey permet de comparer toutes les paires de moyennes et d'y montrer des différences avec un risque alpha. La technique du HSD permet de spécifier un "family confidence level" pour les comparaisons que vous entreprenez, au contraire de la méthode du LSD qui contrôle le niveau d’erreur pour une seule comparaison. L'intervalle du HSD est plus large que celui du LSD, ce qui rend plus difficile de déclarer qu'une paire de moyennes diffère significativement. Le test HSD est de ce fait plus conservatif.

La procédure de Newman-Keuls: C'est une procédure de comparaisons multiple qui permet de comparer toutes les paires de moyennes en contrôlant le risque alpha global, à un niveau défini. C'est une procédure par étape, reposant sur une Studentized range distribution. Bien qu'il ne fournisse pas d'estimation de l'intervalle de différence entre chaque paire de moyennes, il indique quelles moyennes sont significativement différentes des autres.

Les intervalles de Bonferroni : permettent de comparer plusieurs moyennes. Cette méthode s'applique que la taille des groupes soit la même ou non. Utilisant la F-distribution, il génère des intervalles qui permettent de faire un nombre défini de comparaisons linéaires parmi les moyennes de l’échantillon (sample means) tout en contrôlant le taux d’erreur expérimental à un niveau défini (specified level). Dans les procédures des STATLETS ANOVA, le nombre de comparaisons est défini pour vous permettre de comparer les différences entre toutes les paires de moyennes.

Procédure de Duncan : c’est une procédure de comparaisons multiples qui permet de comparer toutes les paires de moyennes, en contrôlant le risque alpha général à un niveau défini. C’est une procédure par étape, reposant sur une Studentized range distribution. Bien qu’elle ne fournisse pas d’estimation d’intervalles pour la différence entre chaque palier de moyennes, cette procédure indique quelles moyennes sont significativement différentes les unes des autres.

Les calculs d'analyse de la variance comme, d'ailleurs, l'emploi du test t de Student-Fisher ou du test F de Snédécor ne sont strictement valables que si les populations échantillonnées sont distribuées selon la loi de Laplace-Gauss (plutôt que " normalement ").

Or, le plus souvent, cette condition n'est qu'approximativement réalisée : la distribution de Laplace-Gauss n'est qu'un modèle théorique, et revêt, par rapport aux distributions réelles, le même degré d'abstraction que les figures géométriques par rapport aux objets réels.

Ainsi, la distribution des prix d'un produit présente, en général, une certaine asymétrie (vers la gauche); mais elle est suffisamment faible pour que cette distribution puisse être considérée, en première approximation, comme normale.

On s'exposerait, au contraire, à des erreurs grossières en étendant ces tests à des données (salaires, tailles des entreprises) dont la distribution est fortement asymétrique.

Cependant, de nombreuses études ont montré que l'analyse de variance est peu sensible à la non-normalité des populations-parents et à l'inégalité des variances. Il suffit en pratique d'éviter son emploi lorsque les distributions des populations-parents sont très différentes (distributions en i ou en j par exemple ou sont de forme très différente de l'une à l'autre (en cloches à dissymétries de sens opposés par exemple) surtout sur de petits échantillons. Il est souvent difficile de contrôler la validité des hypothèses de normalité et d'égalité des variances (données peu nombreuses) ; Il est souvent préférable de tenir compte de l'ensemble des informations dont on dispose a priori au sujet des catégories de variables. De même l'hypothèse d'égalité des variances est secondaire lorsque les effectifs sont égaux. Quand les différentes conditions ne sont pas satisfaites, on peut essayer de s'en rapprocher en essayant de normaliser ces données en leur substituant une variable auxiliaire (par exemple : log de X). Si cette façon de faire ne donne pas satisfaction, on utilisera les tests non-paramétriques.

Colonnes

Variables indépendantes

Variables explicatives

Variable expérimentale, condition expérimentale, traitement

Variables exogènes

échantillons, Groupes, Traitements

Facteurs

Plusieurs colonnes

Variance inter-groupe (concerne la variation induite par les différents échantillons = comparaison des effets des colonnes) = variance inter-traitement

k = nombre d’échantillons à comparer

SCE factorielle

![]()

![]()